Deepseek网络繁忙,数据信息不可暴露,是个人和企业选择本地部署DeepSeek大模型的主要原因,下面我们将介绍如何进行Deepseek大模型的本地部署。

环境准备

| 参数规模 | 适用场景 | CPU配置要求 | GPU配置要求 | 内存要求 | 存储要求 | 网络带宽要求 |

|---|---|---|---|---|---|---|

| 1.5B | 本地测试/轻量级任务 | 4核+(i5/Ryzen 5)5,7 | 非必需(纯CPU推理)5 | 8GB+ DDR45,7 | 256GB+ SSD5 | 千兆以太网6 |

| 7B | 中等复杂度任务/代码生成 | 8核+(i7/Ryzen 7)3,5 | RTX 3070/4060(8GB显存)5,8 | 16GB+ DDR43,5 | 256GB+ NVMe SSD3,5 | 千兆以太网6 |

| 14B | 复杂推理/企业级应用 | 12核+(Xeon Silver)6 | RTX 4090/A5000(24GB显存)4,8 | 32GB DDR54,8 | 1TB NVMe SSD3,4 | 万兆以太网6 |

| 70B | 大规模训练/千级并发 | 64核+(Xeon Gold)1,6 | 8x A100/H100集群(NVLink)1,6 | 512GB+ DDR56 | 4TB+分布式存储1,6 | InfiniBand NDR1,6 |

| 671B | 科研级超大规模训练 | 128核+(EPYC 9684X)6 | 64x H100(NVSwitch集群)6 | 1TB+ ECC DDR56 | 分布式存储系统1,6 | InfiniBand 400G6 |

- GPU显存:每增加10B参数量需额外4-6GB显存4,8

- 存储速度:NVMe SSD相比SATA SSD加载速度提升3倍3,5

- 网络延迟:InfiniBand比普通以太网降低通信延迟85%1,6

- 电源要求:70B以上版本需2000W+冗余电源6

以上是安装DeepSeek大模型各种版本的硬件配置,个人电脑测试推荐安装1.5B&7B,企业级应用推荐14B&70B。

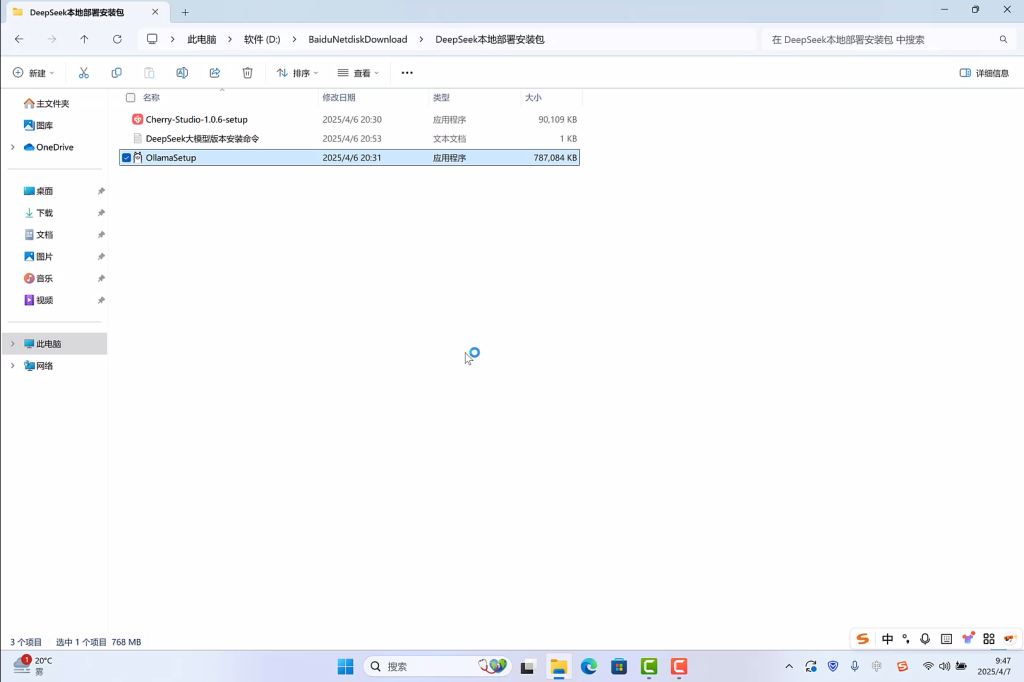

软件准备

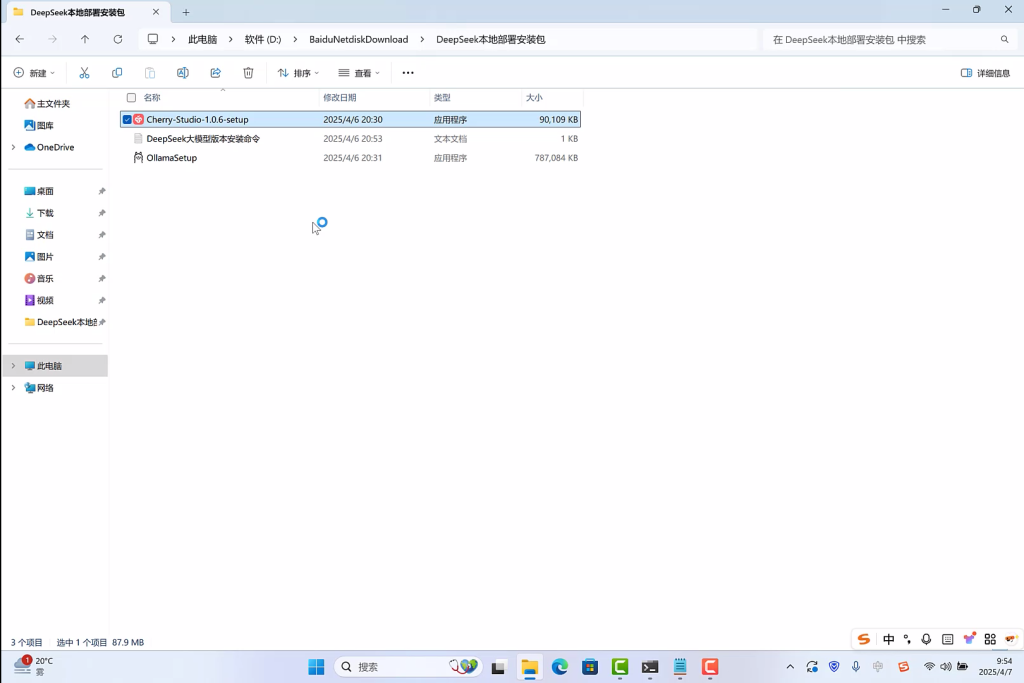

软件需要下载如下安装包:

1.Ollama

2.DeepSeek模型

3.Cherry-Studio

安装包我们都已经都打包好,点击返回首页点击软件下载按钮,即可进入安装包下载页面。

部署模型

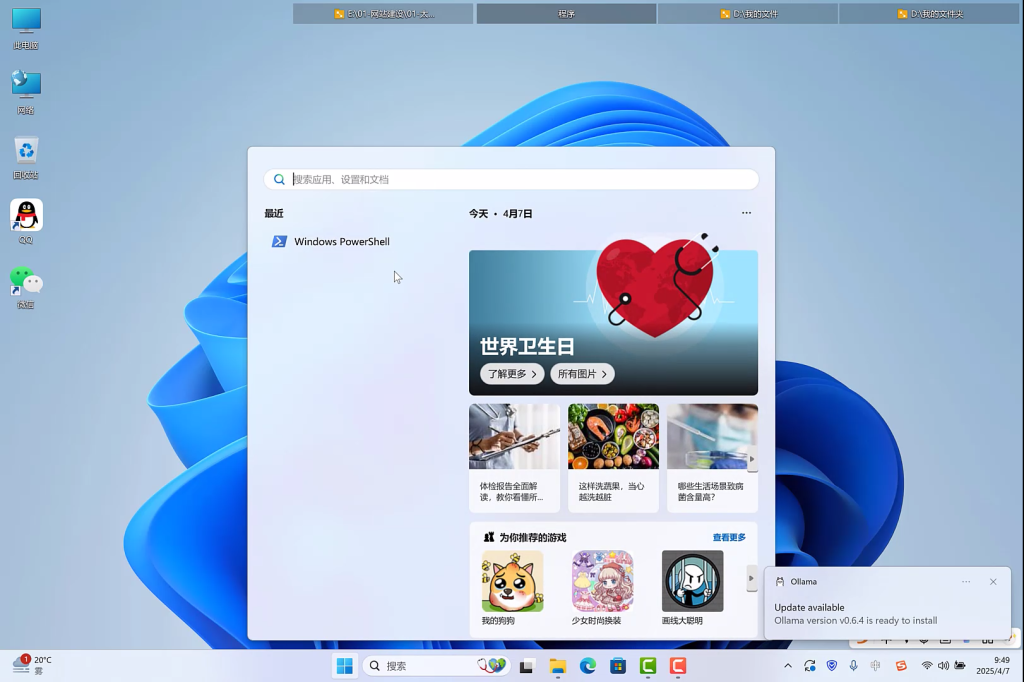

1.首先我们安装Ollama,双击本地部署安装包中的Ollama安装文件,开始安装。

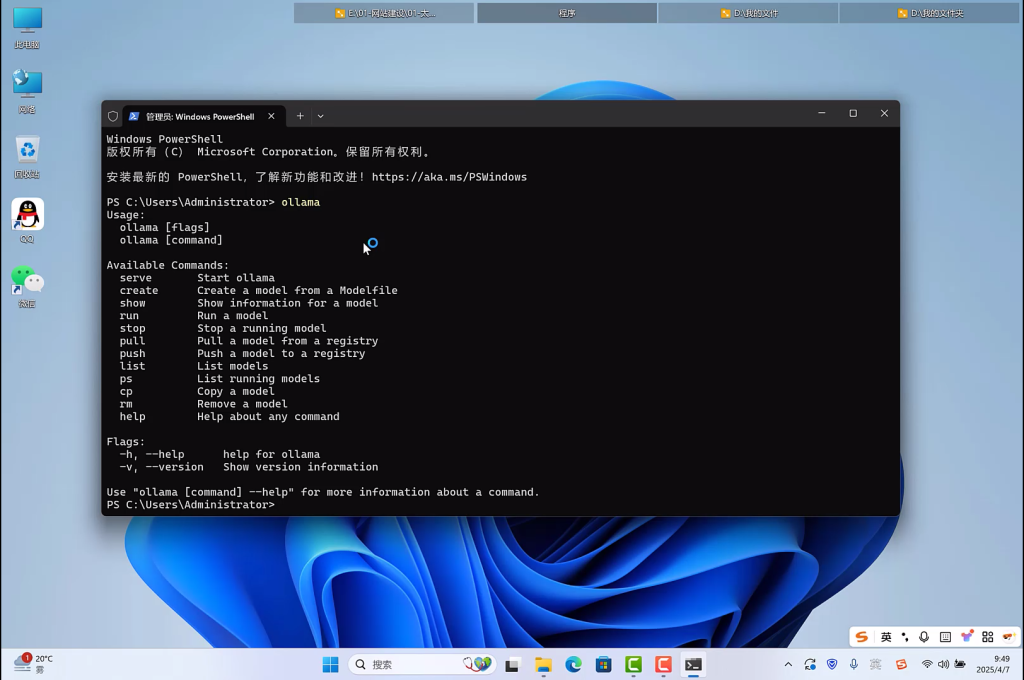

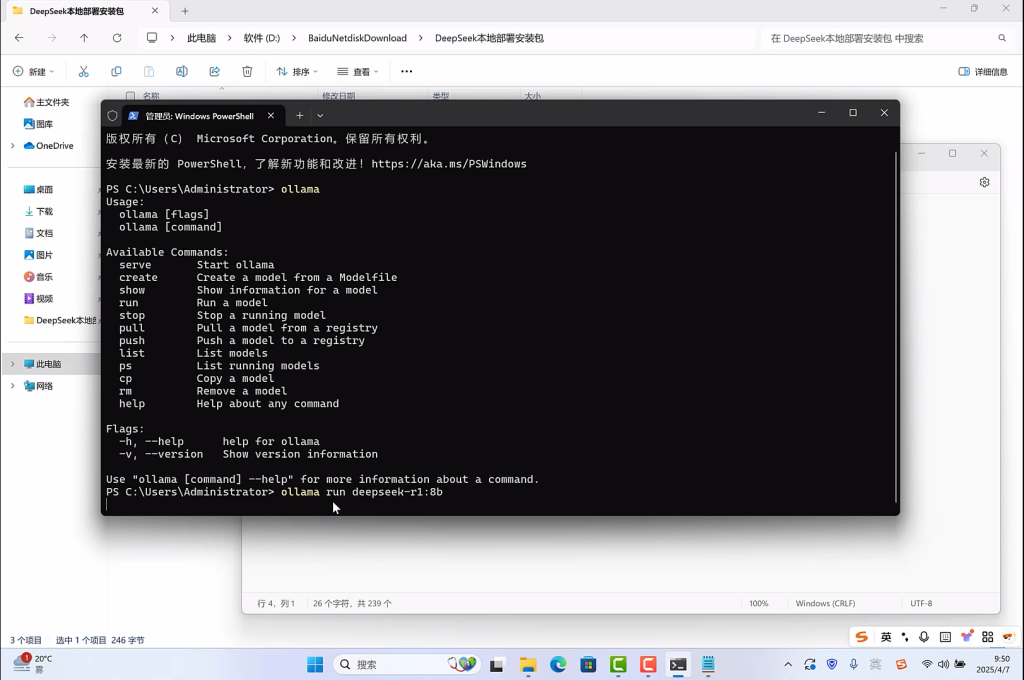

2.ollama安装完毕后,打开Windows PowerShell。

3.在PowerShell中输入ollama,按下回车键,出现如下信息,则ollama安装成功。

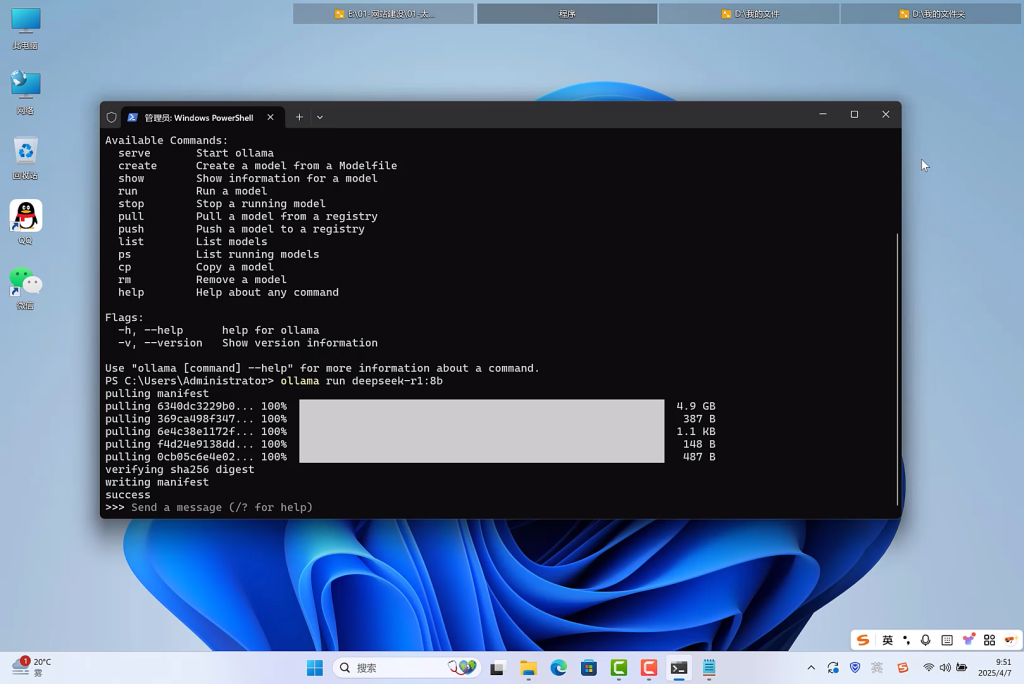

4.打开本地部署安装包中的文档DeepSeek大模型版本安装命令,选择和自己电脑硬件适配的大模型版本,我选择的是8b模型,将命令拷贝到PowerShell中,粘贴并执行命令,开始安装大模型。

5.出现success,代表大模型安装成功。

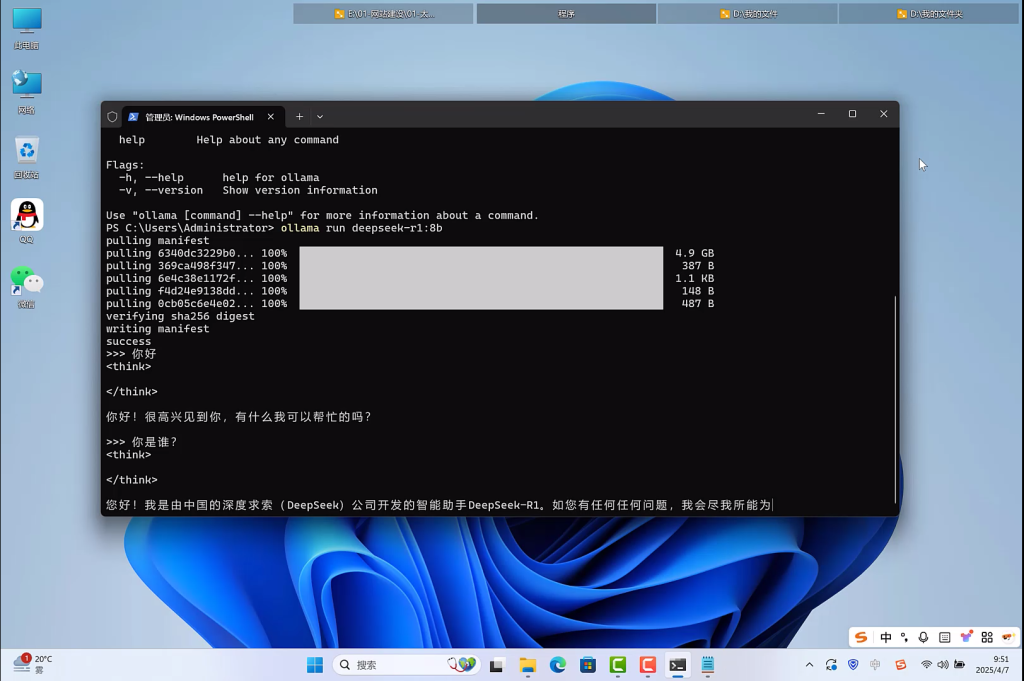

6.输入问题,进行问答测试。

7.使用Power Shell 运行大模型不符合普通人的使用习惯,我们开始安装图形交互软件Cherry-Studio,双击打开软件安装包开始安装。

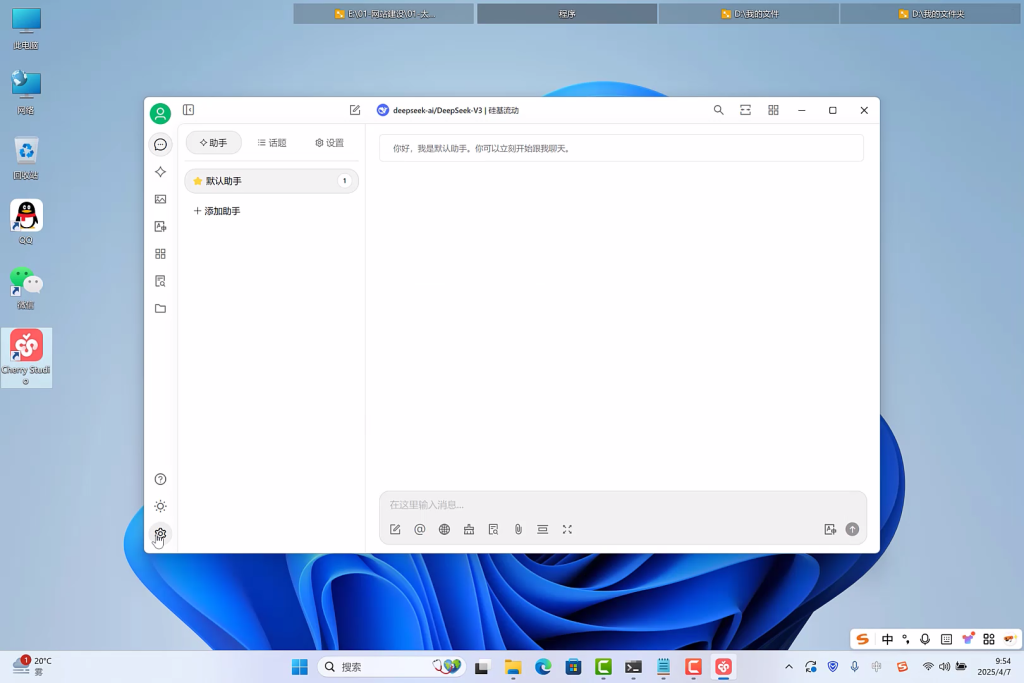

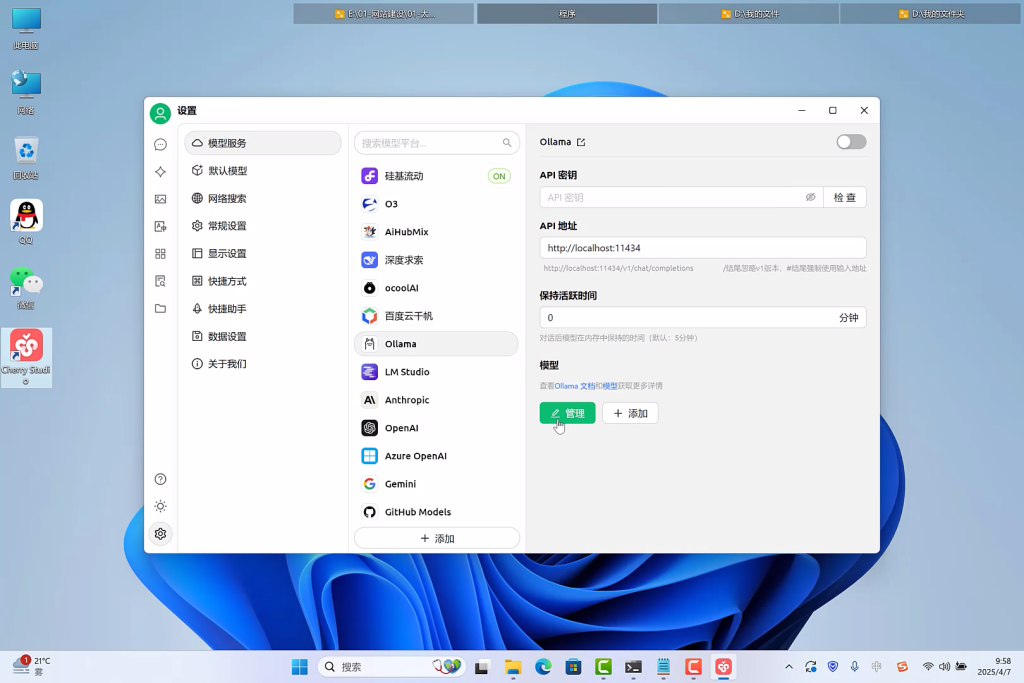

8.安装完毕后,打开Cherry-Studio,点击设置,选中ollama,点击管理按钮。

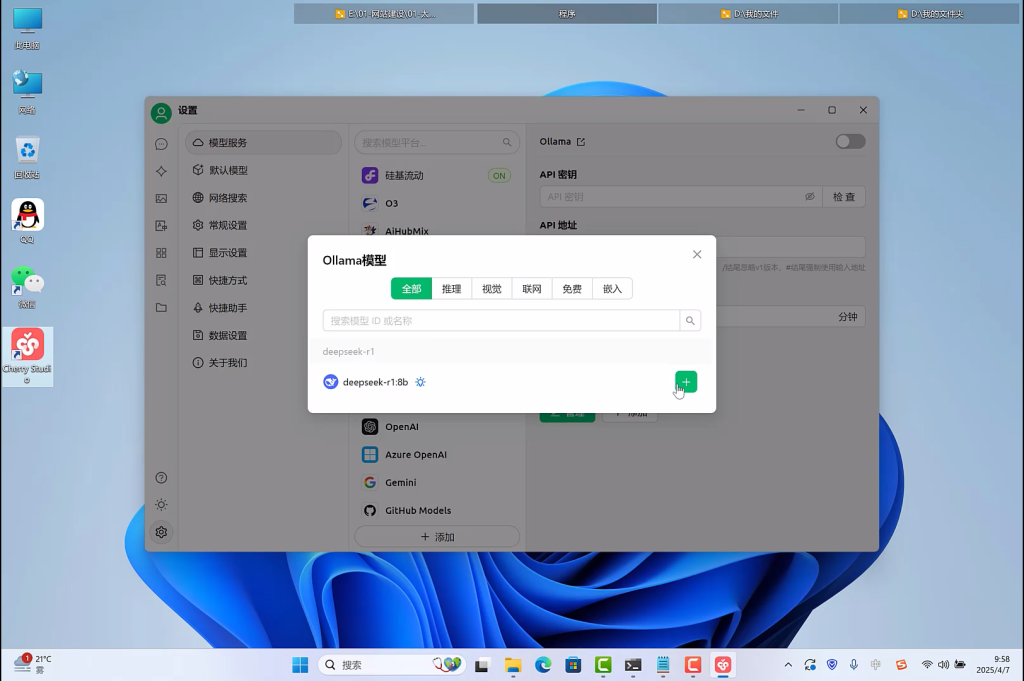

9.在弹出的弹窗中会出现本地安装的所有大模型,例如我们已经安装了deepseek-r1:8b,点击+按钮,将模型添加到软件中。

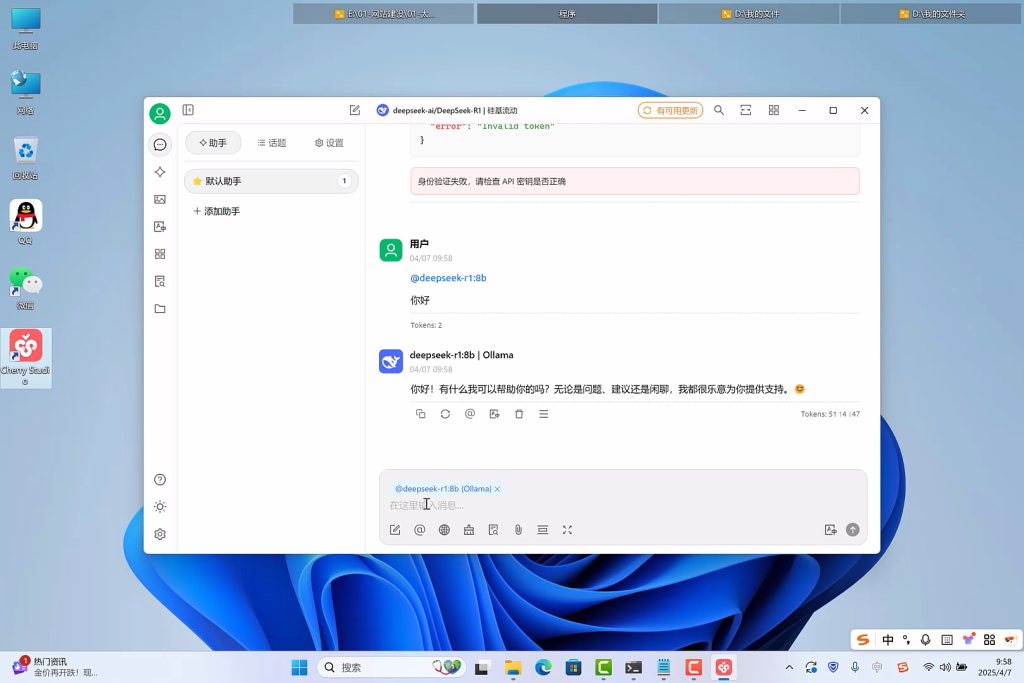

10.返回聊天界面,进行问答测试。

11.大模型本地部署完毕,经过试验,个人电脑配置比较低可以流畅运行1.5b模型,配置比较高,内存在16G以上,可以安装7B模型。

需要下载大模型安装包点击软件下载,需要更详细了解安装流程,可以点击观看视频,我们已经将安装过程录制视频上传到各大视频平台,方便大家观看,如果自己不愿意花时间研究,又想本地部署大模型可以返回首页,点击联系我们。